Διαθέσιμοι υπολογιστικοί πόροι

Η υπολογιστική συστοιχία του ΑΠΘ "Αριστοτέλης" αποτελείται από ετερογενείς υπολογιστικούς κόμβους (compute nodes) που ομαδοποιούνται ανά ουρά (partition). Σε κάθε ουρά οι κόμβοι είναι ομογενείς (ίδιου τύπου) και διασυνδέονται μεταξύ τους είτε μέσω InfiniBand (εύρους 14G ή 200G) είτε μέσω Ethernet (εύρους 1G ή 10G) δικτύων.

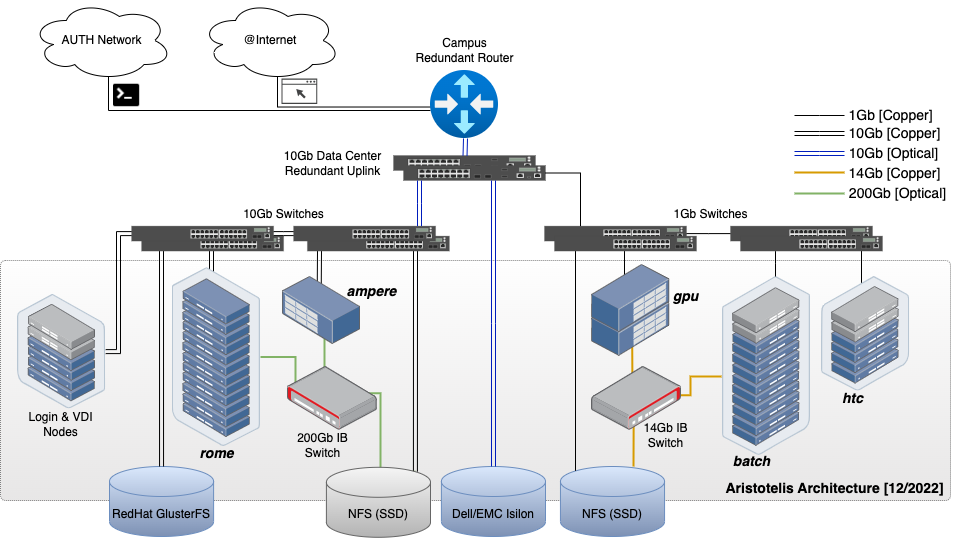

Αρχιτεκτονική συστοιχίας

Τα χαρακτηριστικά των ουρών (partitions) αναλύονται στον παρακάτω πίνακα.

| Ουρά εργασιών | batch | ampere | gpu | rome | a4000 | htc | ondemand | testing |

|---|---|---|---|---|---|---|---|---|

| Πλήθος κόμβων (nodes) | 18 | 1 | 2 | 17 | 1 | 4 | 12 | 2 |

| Πλήθος CPU Cores ανά κόμβο | 20 | 128 | 20 | 128 | 10 | 64 | 12 | 8 |

| Πλήθος Job slots (CPU only jobs) | 360 | 128 | 40 | 2176 | 10 | 256 | 144 | 16 |

| Μνήμη ανά κόμβο[GB] | 128 | 1024 | 128 | 256 or 1024 | 128 | 128 or 256 | 47 | 16 |

| Μοντέλο CPU | Intel Xeon E5-2630 v4 | AMD EPYC 7742 | Intel Xeon E5-2640 v4 | AMD EPYC 7662 | Intel Xeon Silver 4210R CPU | AMD Opteron 6274 | Intel Xeon Gold 6230 (vCPU) | Intel Xeon E5405 |

| Interconnect | 14Gb InfiniBand FDR (οδηγίες) | 200Gb InfiniBand HDR (οδηγίες) | 14Gb InfiniBand FDR (οδηγίες) | 200Gb InfiniBand HDR (οδηγίες) | 1Gb Ethernet | 1Gb Ethernet | 1Gb Ethernet | 1Gb Ethernet |

| Σχόλιο | Η "default" ουρά | Οχτώ κάρτες NVIDIA A100 (40GB DDR6 RAM/κάρτα) σε έναν κόμβο | Μία κάρτα NVIDIA Tesla P100 ανά κόμβο | Ουρά που διατίθεται αποκλειστικά για παράλληλα (mpi ή openmp) jobs. Περισσότερες πληροφορίες ακολουθούν στο infobox παρακάτω. | Μία GPU κάρτα αρχιτεκτονικής Nvidia RTX A4000 με 16GB GDDR6. Ουρά κατάλληλη για απομακρυσμένη επιφάνεια εργασίας, interactive εφαρμογές με γραφικό περιβάλλον και deep learning αλγορίθμους (οδηγίες) | Ουρά που προτείνεται για παραμετρικά (πολλαπλά σειριακά) jobs | Μία virtual GPU κάρτα αρχιτεκτονικής Nvidia Quadro RTX 6000 με 6GB GDDR6. Ουρά κατάλληλη για απομακρυσμένη επιφάνεια εργασίας, interactive εφαρμογές με γραφικό περιβάλλον και deep learning αλγορίθμους (οδηγίες) | Ουρά για δοκιμαστικά μικρά (σύντομα) jobs |

Το λειτουργικό σύστημα όλων των κόμβων είναι Rocky 9 και το Batch system (χρονοδρομολογητής) είναι Slurm.

Χρήση του rome partition

Το rome partition προορίζεται αποκλειστικά για υποβολή παράλληλων εργασιών. Ως εκ τούτου, πριν

υποβάλλετε jobs στο rome partition βεβαιωθείτε ότι η εφαρμογή σας είναι παράλληλη και ότι αξιοποιεί

τους υποκείμενους πόρους (CPU, Memory, Interconnect) σε ικανοποιητικό (ή ιδανικά βέλτιστο) βαθμό.

Για να ελέγξετε αν μία (ολοκληρωμένη) εργασία έχει αξιοποιήσει σε ικανοποιητικό βαθμό τους

υποκείμενους πόρους μπορείτε να χρησιμοποιήσετε την εντολή seff, π.χ.:

# seff jobid

Παράδειγμα seff και επεξήγηση

Στο παρακάτω παράδειγμα βλέπουμε το seff output για μία εργασία που εκτελέστηκε στο batch partition

σε 6 CPU Cores (σε ένα node):

# seff 1584940

Job ID: 1584940

Cluster: aristotle

User/Group: pkoro/pkoro

State: COMPLETED (exit code 0)

Nodes: 1

Cores per node: 6

CPU Utilized: 00:35:42

CPU Efficiency: 97.01% of 00:36:48 core-walltime

Job Wall-clock time: 00:06:08

Memory Utilized: 2.12 GB (estimated maximum)

Memory Efficiency: 5.63% of 37.69 GB (6.28 GB/core)

Παρατηρούμε ότι έχει μετρηθεί πολύ καλό CPU efficiency (97.01%) οπότε το job κρίνεται κατάλληλο για να

υποβληθεί στο rome partition. Η αξιολόγηση αυτή θα πρέπει να επαναλαμβάνεται όσο αυξάνουμε το πλήθος

των CPU Cores.

Ενέργεις διαχειριστών

Εφόσον διαπιστωθεί να εκτελούνται εργασίες που δεν αξιοποιούν επαρκώς (π.χ. σε ποσοστό 60% ή μεγαλύτερο) τους υποκείμενους πόρους ο χρήστης θα ενημερώνεται άμεσα με αυτοματοποιημένο μήνυμα για το πρόβλημα και οι εργασίες θα ακυρώνονται.

Απορίες ως προς το job efficiency

Για οποιαδήποτε απορία ή βοήθεια θα θέλατε ως προς θέματα παραλληλίας και job efficiency παρακαλούμε επικοινωνήστε μαζί μας στο hpc-support@auth.gr.

Partition Limits¶

Τα παρακάτω όρια καθορίζονται για τις ουρές εργασιών (partitions) της συστοιχίας μέσω του Slurm batch system.

| Ουρά εργασιών | batch | ampere | gpu | rome | htc | ondemand | testing |

|---|---|---|---|---|---|---|---|

| Max CPUs per user | 140 | no limit | no limit | 1024 | 200 | 12 | no limit |

| Max Running jobs per user | 20 | 6 | no limit | 32 | 200 | 4 | no limit |

| Max Submitted jobs per user | 500 | 20 | no limit | 40 | 2000 | 8 | no limit |

| Max Nodes per job | 5 | no limit | no limit | no limit | 3 | 1 | no limit |

| Max Runtime per job | 7 days | 6 hours | 1 day | 2 days | 9 days | 2 days | 1 day |

| Min CPUs per job | 1 | 1 | 1 | 8 | 1 | 1 | 1 |

| Min GPUs per job | 0 | 1 | 1 | 0 | 0 | 0 | 0 |

| Max GPUs per job | 0 | 8 | 2 | 0 | 0 | 0 | 0 |

Δυνατότητα επέκτασης χρονικών ορίων

Στις ουρές batch, rome και ampere υπάρχει δυνατότητα επέκτασης του μέγιστου χρονικού ορίου

με χρήση ενός εκ των παρακάτω QoS (Quality of Service):

| Partition | QoS | Additional imposed limitations | Max walltime |

|---|---|---|---|

batch |

batch-extd |

max running CPUs = 40 |

12 days |

rome |

rome-extd |

max running CPUs = 384 |

12 days |

ampere |

ampere-extd |

max running GPUs = 4 |

6 days |

Για να δοθεί η δυνατότητα χρήσης ενός από τα παραπάνω QoS ο/η ενδιαφερόμενος/-η χρήστης

θα πρέπει να επικοινωνήσει με το hpc-support@auth.gr.

Εφόσον υπάρχει πρόσβαση σε αναβαθμισμένο QoS, θα πρέπει στο script υποβολής κάθε εργασίας

να επιλέξουμε αν θέλουμε να χρησιμοποιηθεί το απλό QoS ή το αναβαθμισμένο, μέσω της παραμέτρου

qos. Δείτε περισσότερες λεπτομέρειες για τη χρήση της παραμέτρου qos.